近期DeepSeek凭借其卓越的性能而迅速走红,吸引了众多开发者和企业的关注。作为一款领先的AI大模型,其结合了最新的深度学习技术、超大规模训练数据和高性能计算架构,专注于自然语言处理和大规模数据推理,为企业和开发者提供强大的 AI 能力。

然而针对智能机器人、工业自动化、无人设备等对低时延、低宽带和高安全性要求的场景中,如何摆脱对云端计算依赖,在边缘设备上本地部署AI模型变得至关重要。为此,本文选用我司自研的RTSS-X102智盒搭载 Jetson Orin 64GB模块,分享DeepSeek-R1模型本地部署和应用的过程。

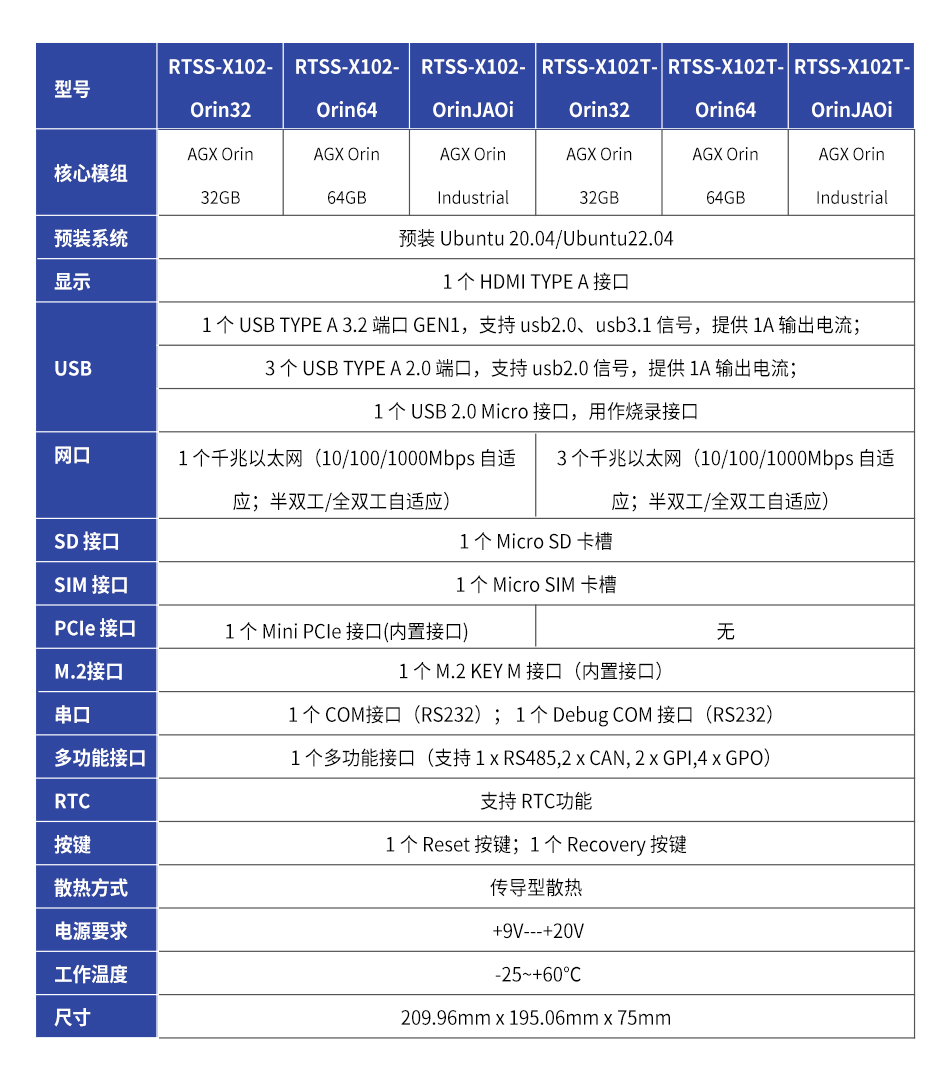

RTSS-X102是针对NVIDIA Jetson AGX Orin设计的智能计算设备, 广泛应用于需要高性能计算和 AI 推理的场景,旨在满足边缘计算、人工智能和嵌入式应用等领域的高性能边缘AI需求。主要特点如下:

本次采用的RTSS-X102整机搭载Jetson Orin 64GB模组,配备12核 Arm Cortex-A78AE CPU、2048核 NVIDIA Ampere 架构 GPU 及64个 Tensor Core,整体算力高达 275 TOPS,并配有 64GB LPDDR5 高速内存,为 DeepSeek 提供了强大而稳定的算力支持。

部署前先按产品指导手册完成了镜像和BSP包烧写。若有多模型部署的需要,需提前预装 M.2接口SSD将模型和数据保存至硬盘。

系统启动后,执行以下命令安装Ollama。Ollama是一个搭载大模型的容器,要想让DeepSeek-R1、LLaVA等模型在本地部署和运行,需要先把Ollama配好。安装过程中如果遇到网络问题而导致下载失败,可通过修改国内镜像源或添加代理解决。

# 安装 Ollama curl -fsSL https://ollama.com/install.sh | sh

安装好后就可以执行命令来拉取DeepSeek模型了,下面汇总了拉取 DeepSeek-1.5b、7b、8b、14b、32b模型的命令。(注:模型若想要保存到外接硬盘,得提前挂载SSD分区并在ollama.service中添加模型 保存路径的环境变量)

# 下载 DeepSeek-R1 模型 ollama pull deepseek-r1:1.5b ollama pull deepseek-r1:7b ollama pull deepseek-r1:8b ollama pull deepseek-r1:14b ollama pull deepseek-r1:32b

把模型部署到本地后,就可以在终端下初步使用了。

# 运行Deepseek-r1:8b,添加--verbose可查看tokens信息 ollama run deepseek-r1:8b

Ollama本身提供的是一个极客风格的终端聊天界面,对普通用户而言终归不友好,这就得依靠Open WebUI给大模型加个壳壳。Open WebUI是一个开源的 Web 用户界面框架,其风格酷似ChatGPT。用户可以在浏览器输入网址,选定要用的模型后就能输入文字与之交互。

本文安装Open WebUI需要依赖Docker环境,安装Docker一行命令即可搞定:

# Docker安装

curl -fsSL

https://get.docker.com

| bash

Docker安装好后,运行下面的命令来拉取和运行Open web UI镜像。(注:-v用于绑定本地目录,使容器和宿主机之间共享文件或文件夹,请按个人需求配置)

docker run -d --network=host \

-p 8080:8080 \

--name open-webui \

-v open-webui:/app/backend/data \

-v /home/nvidia/ssd/ollama_models:/app/model \

-e ENABLE_OLLAMA_API=True \

-e OLLAMA_BASE_URL=http://127.0.0.1:11434 \

--restart always \

ghcr.io

/open-webui/open-webui:main

容器运行起来后,在局域网内访问 http://(目标IP地址):8080,就可以愉快体验DeepSeek大模型的推理功能啦!

不同参数规模的模型在 RTSS-X102 智能盒上推理时,其 Token 处理速率如下表所示,可以看到整体表现出色,性能十分强劲。

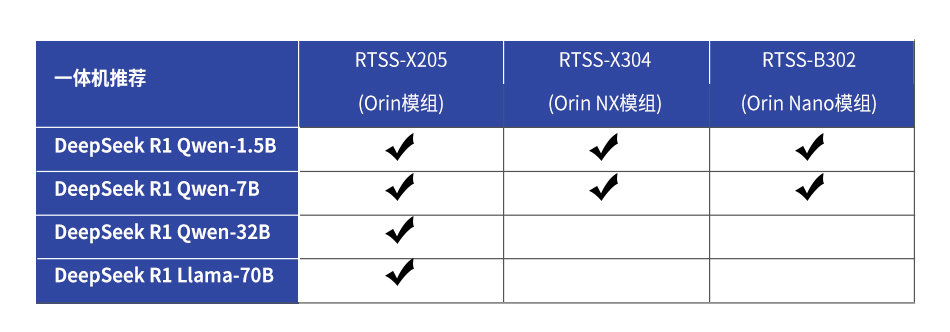

以下是我司针对本次DeepSeek 模型在边缘侧部署精心推荐的产品型号。如您有相关需求,欢迎随时与我们联系,我们将竭诚为您提供支持与服务。

瑞泰新时代专注于提供高度定制化的载板与智能盒解决方案,能够根据客户的具体需求,精心设计软硬件系统的每一个细节。同时,我们配备全方位的技术支持服务,助力项目高效、精准地实施与落地。

联系人:Realtimes

服务热线: 400-100-8358

邮箱:info@realtimes.cn

地址: 北京市朝阳区和平西街和平西苑20号B座11层